miiboDesigner の岡大徳です。

miiboが大きなアップデートを実施しました!API経由でしか利用できないOpenAIの最新モデル「GPT-4.1シリーズ」に対応したことをお知らせします。GPT-4.1、GPT-4.1 mini、GPT-4.1 nanoの3つの新モデルが使えるようになり、プログラミング知識がなくても高性能な会話型AIを構築できるようになりました。コーディング能力の大幅向上、指示への対応改善、100万トークンの長文処理など、魅力的な特長を持つこれらのモデルをmiiboでどう活用できるか解説します。

GPT-4.1シリーズとは?3つの新モデルの特徴

OpenAIが4月にリリースした新モデル「GPT-4.1シリーズ」は、ChatGPTでは使えないAPI限定のモデルです。最新の技術を取り入れつつも、前モデルよりも低コストで高性能という画期的な特長を持っています。

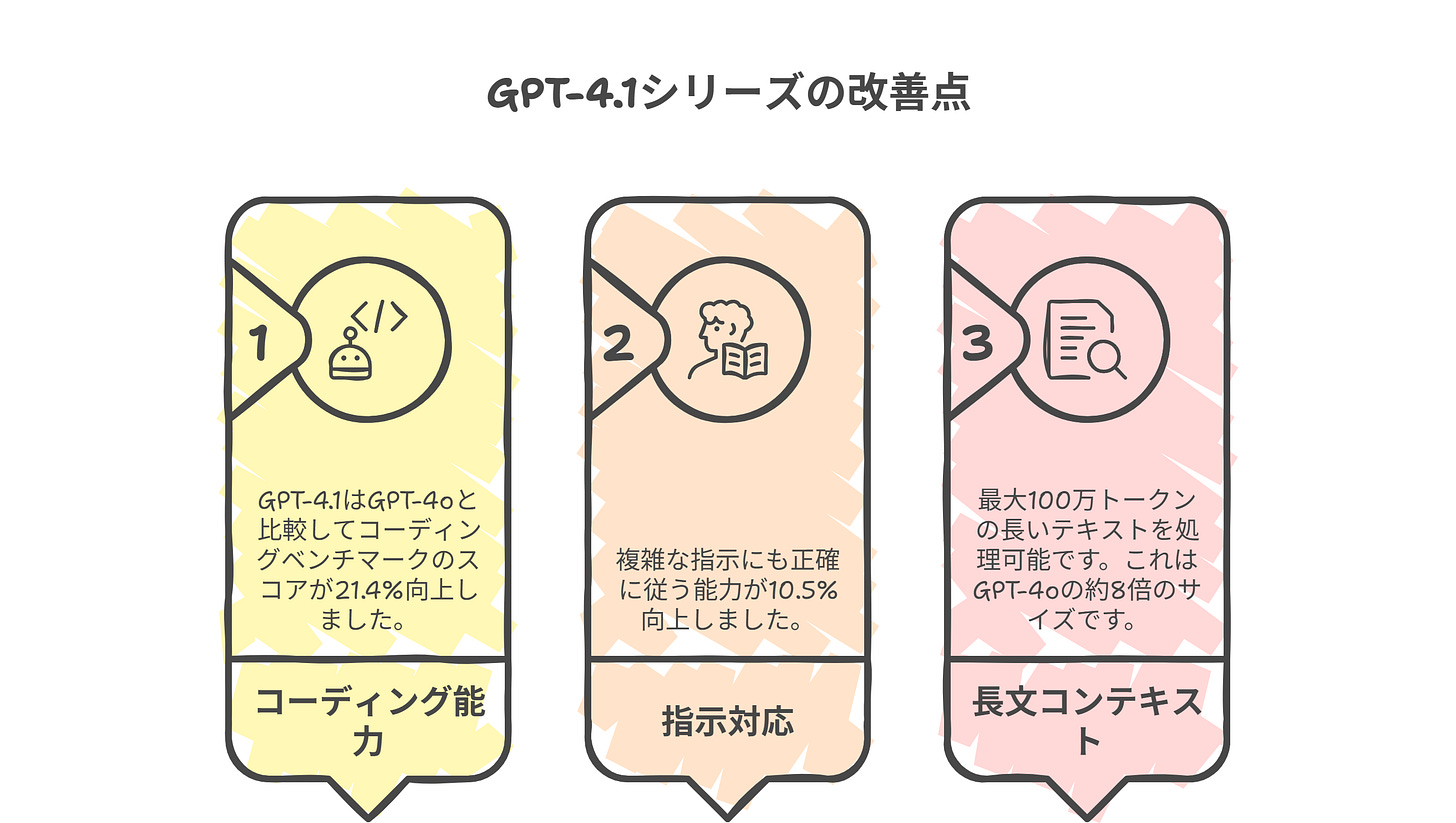

特に注目すべき改善点は以下の3つです:

コーディング能力の大幅向上: GPT-4.1はGPT-4oと比較してコーディングベンチマークのスコアが21.4%向上

指示対応の改善: 複雑な指示にも正確に従う能力が10.5%向上

長文コンテキスト: 最大100万トークン(GPT-4oの約8倍)の長いテキストを処理可能

3つのモデルの違いと使い分け

各モデルには明確な特徴と適した用途があります:

GPT-4.1: 最も高性能なモデルで、複雑なコーディングや高度な推論タスクに最適

コスト: 入力$2.00/百万トークン、出力$8.00/百万トークン

GPT-4oよりも26%低コスト

GPT-4.1 mini: 中規模モデルながら、多くのベンチマークでGPT-4oを上回る性能

コスト: 入力$0.40/百万トークン、出力$1.60/百万トークン

GPT-4.1の約1/5の価格で、多くのタスクで十分な性能

GPT-4.1 nano: 最も高速・低コストで、基本的なタスクに最適

コスト: 入力$0.10/百万トークン、出力$0.40/百万トークン

シンプルな応答や分類タスクに最適

プロンプトキャッシュ機能の強化

GPT-4.1シリーズでは、プロンプトキャッシュ機能が大幅に強化されました。この機能により、キャッシュ使用時のコスト削減率が従来の50%から75%に向上しています。

プロンプトキャッシュとは

プロンプトキャッシュは、1,024トークン以上のプロンプトに対して、レイテンシーを最大80%、コストを75%削減できる機能です。miiboでモデルを選択すると自動的に適用され、OpenAIのAPIキーを登録している方は、API料金の削減につながります。

仕組みとしては、プロンプトの先頭部分(プレフィックス)がキャッシュにあるか確認します。キャッシュヒットの場合、処理が高速化され、コスト削減が適用されます。キャッシュは通常5〜10分間有効で、オフピーク時は最大1時間持続します。

効果的な活用方法

プロンプトキャッシュ機能を最大限に活用するためのコツは以下の通りです:

プロンプトを約1,000文字以上に設定する

静的なパート(ステートなど可変の項目を含まない)をプロンプトの前半に配置する

同じナレッジベースを使う複数の質問処理など、反復的な処理に活用する

これにより、特に以下のようなケースで大幅なコスト削減が可能になります:

同じベースプロンプトに対する複数のユーザーからの質問

類似した分析や処理を繰り返し実行する場合

大規模文書を参照する多数のAI応答

現在のキャッシュ対応モデルは、GPT-4o、GPT-4o-mini、o1-preview、o1-mini、GPT-4.1、GPT-4.1 mini、GPT-4.1 nanoです。

miiboでの活用ポイント:ユースケース別ガイド

GPT-4.1シリーズの強みを活かした具体的なユースケースを紹介します。

1. 大規模コードベース分析と自動コード生成

GPT-4.1の100万トークンコンテキストを活用すれば、大規模なコードベース全体を一度に読み込み、理解した上でコード生成が可能になります。

活用例:

社内の大規模なコードリポジトリを読み込み、バグ修正や機能追加の提案

複数のファイルにまたがる変更を一括で提案

コーディング規約に基づいたコード自動レビュー

miiboではプログラミング不要でこれらの機能を実装できるため、エンジニアでなくてもコード関連の業務効率化が可能です。

2. 低コストでの大量文書処理

GPT-4.1 miniを使えば、GPT-4oの1/5程度のコストで多くの文書処理が可能になります。

活用例:

大量の顧客サポート応対を自動化

社内文書・マニュアルの検索と要約

複数言語での情報提供

月間のトークン使用量が多い場合、GPT-4.1 miniへの切り替えだけで大幅なコスト削減が期待できます。

3. 超高速レスポンスのフロントライン対応

GPT-4.1 nanoは応答速度が非常に速いため、初期対応や基本的な質問への回答に最適です。

活用例:

Webサイト訪問者への即時対応

よくある質問への自動応答

ユーザー意図の分類と適切な部門への振り分け

miiboでの実装方法:簡単3ステップ

GPT-4.1シリーズをmiiboで利用するのは非常に簡単です。

ステップ1:モデル選択

エージェント設定画面で「言語モデル」項目を開く

GPT-4.1、GPT-4.1 mini、GPT-4.1 nanoのいずれかを選択

ステップ2:コンテキスト設定

大規模データを扱う場合は、プロンプト設定で長いコンテキスト活用を明示

必要に応じて「ナレッジデータストア」でデータを追加

ステップ3:テストと最適化

「会話をテスト」機能でエージェントの応答を確認

必要に応じてモデルの切り替えや設定の調整

モデル選択の最適化戦略

目的に合わせた最適なモデル選択のポイントを紹介します:

精度と品質が最重要: GPT-4.1

法律、医療、金融など高度な専門知識が必要な場合

複雑なコード生成や解析が必要な場合

コストとパフォーマンスのバランス: GPT-4.1 mini

一般的なカスタマーサポート

社内ナレッジベース

中程度の複雑さのコーディングタスク

応答速度と大量処理が重要: GPT-4.1 nano

初期スクリーニングや分類タスク

大量の簡易質問への対応

基本的な情報提供

Q&A

Q: 既存のGPT-4oを使ったエージェントをGPT-4.1に移行する際の注意点は?

A: 基本的にはモデルの選択を変更するだけで移行できますが、GPT-4.1はより指示に忠実なため、プロンプトの表現をより明確にすることをお勧めします。また、長いコンテキストを活用するためには、プロンプト設計を見直すと効果的です。

Q: GPT-4.1 nanoでも100万トークンのコンテキスト処理は可能ですか?

A: はい、GPT-4.1シリーズのすべてのモデル(GPT-4.1、mini、nano)が100万トークンまでのコンテキスト処理に対応しています。ただし、nanoは処理速度と解釈精度のバランスを考慮して活用することをお勧めします。

Q: プロンプトキャッシュ機能を効果的に使うコツはありますか?

A: プロンプトの先頭部分に固定のテキスト(変化しない指示や説明など)を配置し、可変部分(ユーザーの質問やステート情報など)を後半に配置すると効果的です。また、同じプロンプト構造を複数のエージェントで共有することでも、キャッシュヒット率を高めることができます。

miiboの詳細なFAQについては、以下のURLをご覧ください: https://daitoku0110.net/faq/

まとめ

miiboのGPT-4.1シリーズ対応は、会話型AI構築の可能性を大きく広げる重要なアップデートです。より高性能で低コスト、そして100万トークンという大規模コンテキスト処理能力を持つこれらの新モデルを活用することで、より多様で高度なAIエージェントの構築が可能になります。

特に注目すべきは:

コーディング能力の大幅向上

指示への対応精度の向上

長いコンテキスト処理能力

従来モデルと比較して最大26%のコスト削減

プロンプトキャッシュによる最大75%の追加コスト削減

これらの特長を活かして、ビジネスでの会話型AI活用をさらに加速させることができます。

【今すぐ行動】

新モデルの性能とコスト削減効果を体験してみませんか?まずは既存のエージェントのモデル設定をGPT-4.1シリーズに変更して、その性能差を確認してみましょう。さらに、プロンプト設計を最適化してキャッシュ機能の恩恵を最大化することで、さらなるコスト効率向上が期待できます。

→ miiboダッシュボードへアクセス:https://miibo.dev/auth/login

それでは、また次回のニュースレターでお会いしましょう! miiboを楽しんでください!

miiboDesigner岡大徳:https://daitoku0110.net/

miiboガイドページ:https://daitoku0110.net/miibo-guide/

miiboDesigner岡大徳が徹底解説、「miibo」の全貌と描く未来:https://miibo.site/